Forskar Kuldova ut mot mannssjåvinistisk kunstig intelligens

Kunstig intelligens kan gjere at vi mistar rettane som vi har kjempa for og tek for gitt, meiner Tereza Kuldova.

OBS! Denne artikkelen er mer enn tre år gammel, og kan inneholde utdatert informasjon.

Dette bryr ho seg verkeleg om. Det er det første eg tenker når eg møter forskar II ved OsloMet, Tereza Kuldova.

På ein kafé på OsloMet sin campus i Pilestredet i Oslo, sit ho benka og førebudd til å snakke om eit tema ho brenn for. Ikkje berre med Khrono, men på eit arrangement i høve kvinnedagen 8. mars.

Ho skal snakke om algoritmer og kunstig intelligens. Spørsmålet ho skal svare på er om algoritmer er sexistiske. Før eg i det heile har hatt høve til å spørje, så kjem det svar på løpande band på dei aller fleste spørsmåla eg har førebudd.

Det er ikkje tvil om at svaret på spørsmålet er ja på måten Kuldova snakkar om kunstig intelligens.

— Kvinner er underrepresenterte når ein trener opp algoritmer. Dei blir fôra med data og lærer seg menneskelege fordommar, som ofte blir forsterka. Store deler av dataen som blir treningsgrunnlaget til algoritmene er frå vestlige land, der verkelegheita til ein kvit mann er overrepresentert, seier Kuldova og slår tidleg fast at dei ikkje berre er mannssjåvinistiske, men også rasistiske og i høgaste grad politiske.

Det er kanskje ikkje overraskande, om ein skal tru ein heilt ny FN-studie som viser at 9 av 10 har ei slagside til fordel for menn.

Kuldova legg til:

— Men ein må ikkje tru at berre ved å få fleire kvinner inn i teknologien, i selskapa, det vere seg fleirkulturelle kvinner eller arbeiderklassekvinner, så er problema løyste. Problema ligg i teoriane som den kunstige intelligensen er trent ut frå og makta som ligg i det. Kunstig intelligens kan gjere at vi mistar rettane som vi har kjempa for og tek for gitt.

Kuldova fortel om då ho før Cambridge Analytica-skandalen, prøvde seg på ein av algoritmene til selskapet. I staden for å la selskapet få lese Facebook-profilen hennar, så la ho inn ein akademisk artikkel ho hadde publisert.

Utslaget: Den kunstige intelligensen vurderte at Kuldova med 99,9 prosent sannsynlegheit var mann.

— Kva slags teori er då denne algoritmen trent på? Kva slags teori har den lært om kva ei kvinne er? At kvinner har eit meir emosjonelt språk? spør Kuldova.

Som ho seier, «if you put garabage in, you get garbage out». Og det er nettopp slik algoritmene fungerer.

Kunstig intelligens

Kunstig intelligens og algoritmer er ikkje som eit vanleg dataprogram, som er prisgitt menneskelege val. Om ein trykker 1 + 2 så vil dataprogrammet gi oss 3 kvar gong. Men algoritmer og kunstig intelligens lærer sjølv, basert på den dataen den blir fôra med.

Blir den fôra med mange bilete av kvinner på kjøkkenet og menn i dress på eit kontor, så vil den til slutt trene seg til å tru at verkelegheita er slik. Men den vil då også identifisere eit bilete av ein mann på eit kjøkken som ei kvinne.

Og den vil gjere vurderingar og kan lande på eit svar med denne verkelegheita som base. Og kome til ein sannsynleg «fasit».

Utslaget kan bli at jobbannonser for sjefsstillingar blir vist til mannelege søkarar seks gongar så ofte som til kvinnelege, som forskarar frå Carnegie Mellon fann at Google sine algoritmer gjorde.

Denne teknologien styrer i aukande grad kvardagen vår. I alt frå kva slags reklame vi ser til om vi får innvilga lån eller blir flagga som medlemmar av ei risikogruppe, det vere seg terrorisme eller barnemishandling, så kan avgjerdene bli tekne av kunstig intelligens, ifølgje Kuldova.

Farane

Tilbake på kafeen på OsloMet-campusen, fortel sosialantropologen Kuldova om eit lite eksperiment som ho sjølv gjorde i samband med hennar innlegg på kvinnedags-arrangementet.

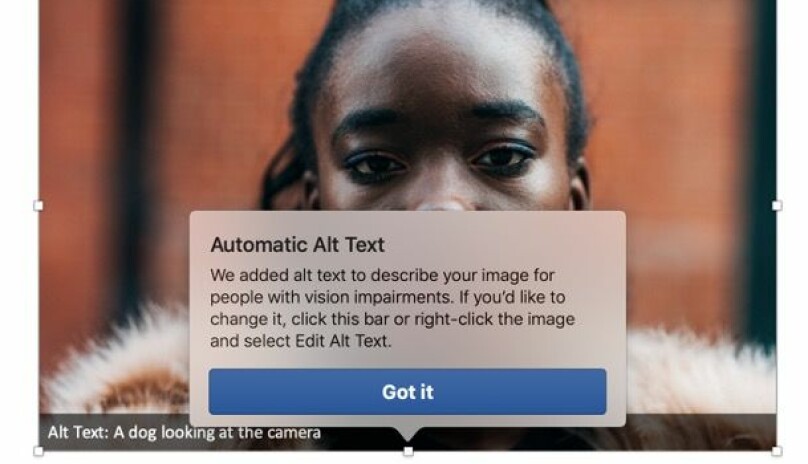

Microsoft har nemleg utvikla kunstig intelligens som er trent til å sjå kva som er på eit bilete. Og beskrive det for til dømes svaksynte. Så Kuldova lasta opp eit bilete av ei svart kvinne i tekstprogrammet Word.

— Så kjem den alternative teksta opp: A dog looking into a camera, seier ein sjokkert Kuldova og viser oss på dataen sin.

— Det at vi får lese dette er jo isolert sett provoserande, men ikkje livstruande farleg. Men det er når same type teknologi skal brukast til styring og predikering av til dømes politiet, grensevakter og Nav at vi har eit problem. Då er ein nødt til å stille seg spørsmålet kva dette faktisk gjer med samfunnet, seier Kuldova. Ho legg til:

— Det at teknologien finst betyr ikkje at vi må ta den i bruk. Dette er eit fundamentalt politisk spørsmål.

Kuldova snakkar om farane og fallgruvene ved kunstig intelligens og kjem med fleire døme. Ho fortel om korleis det har blitt brukt til å vurdere om folk skal få velferdsytingar i Storbritannia, men der menneska ikkje har klart å få innsikt i korleis algoritmen har bestemt seg for kven som skal få og ikkje.

Og om utslaget det gjorde i forsikringsindustrien i Storbritannia. Trass i at EU i 2012 gjorde det ulovleg å bruke kjønn som ein variabel for å gjere risikovurderingar for forsikringar, så klarer algoritmene likevel å finne det sannsynleg kva slags kjønn du er.

— Tidlegare var det slik at du som mann måtte betale rundt 30 pund meir enn ei kvinne for ei bilforsikring. Men etter at det vart ulovleg å bruke kjønn som variabel, byrja algoritmene å leite i anna data, såkalla proxy-data, som kunne bidra til å vurdere risikoen. Det som skjedde var at skilnaden plutseleg vart på rundt 100 pund mellom menn og kvinner, seier Kuldova. Ho legg til:

— Det handlar ikkje om at algoritmen veit sikkert at du er mann eller kvinne, men det handlar om at dei kan finne ut kva sannsynlegheita for det eine eller andre er.

Teoriar

Så var det dette med teoriane då. Dei vitskapelege teoriane som algoritmene er trente ut i frå.

Kuldova fortel om eit forskingsprosjekt som er finansiert av EUs forskingsprogram Horisont 2020. Det heiter IBorderCtrl og målet er å utvikle kunstig intelligens som grensekontrollørane kan bruke ved EUs yttergrenser.

Algoritmene baserer seg på ein teori utvikla av psykologen Paul Ekman, fortel Kuldova, som handlar om at ein kan lese personar sine følelsar gjennom ansiktsuttrykket deira.

— Algoritmene skal altså gi risikovurderingar på folk som vil ta seg inn i EU basert på ansiktsuttrykket deira, trynefaktoren. Den skal fungere som ein slags løgndetektor, seier Kuldova og ristar på hovudet.

Ifølgje Kuldova har dei fôra algoritmen med ansiktsuttrykka til 32 profesjonelle skodespelarar, som skulle spele om dei fortalte sanninga eller laug. Ho fortel at prosjektet har møtt kritikk:

— På den eine sidan har du ein dårleg teori i botnen og i tillegg trener du algoritmen med uttrykka til profesjonelle skodespelarar. Her har du eit fundementalt problem. Det er politisk styrt, såkalla «teknosjåvinistisk» forsking, der målet er å drive kontroll av folk ved grensene, og det er dårleg vitskapeleg fundert, seier Kuldova.

«Objektive» data

Det er ein annan måte kunstig intelligens no blir testa ut og brukt på, som Kuldova har bite seg spesielt merke i og som ho sjølv har skrive artiklar om. Det er korleis politiet brukar algoritmene til å føreseie kven som vil gjere kriminelle handlingar.

Poenget hennar er at algoritmene er føreseielege, men det er ikkje menneske. Ho brukar seg sjølv og si forskarkarriere som eksempel:

— Ikkje ei einaste algoritme ville ha klart å pønske ut eller føreseie at eg, ei tsjekkisk jente, ville kome til Norge og gå frå å forske på den indiske moteindustrien til å byrje å forske på motorsykkelklubbar, seier Kuldova. Ho legg til:

— Ei algoritme vil gå ut frå at folk ikkje endrast, at alt er historisk gitt. Så om du har gjort noko kriminelt ein gong i livet ditt, så vil det bli veldig vanskeleg å kome seg eg ut av den boksen som algoritmen har skapt. Den vil gå ut i frå at det er stor sannsynlegheit for at du vil kunne gjere det igjen. Historiske data blir korrelerte med blant anna demografiske data. Den vil prøve å reprodusere det som var og forsterke ein type verkelegheit. Denne typen risikobasert styring handlar om å føreseie framtida, seier Kuldova.

Ein vil aldri få eit heilt nøytralt datasett, det er umogleg. Det vil alltid vere sosiale fordommar som dei som lagar datasettet ikkje sjølve ser.

Ho verkar oppgitt og seier:

— Men dette blir fort sett på som objektivt, fordi det er harde data. Det er ein datafetisjisme som rår. Men verda er full av avvik, dei fleste av oss er det samanlikna med statistiske modellar — og det er vår styrke som menneske, ikkje svakheit. Difor må vi tenke kritisk om data og kunstig intelligens, slår Kuldova fast.

Ho opplever at samfunnsideologien har blitt sterkt påverka av innovasjonen og framtidstenkinga rundt algoritmene, og svara dei kan gi i møte med alle truslane ein står overfor.

— Ein søker sanninga og dei harde fakta. Så kjem plutseleg denne teknologien og seier dei har svaret. Ein blir fortalt at det er denne typen «reine» data ein kan stole på. Det er ein teorilaus, positivistisk reinskapsideologi som får stadig meir makt. Og vi veit at reinskapsideologiar er vegen til helvete, seier Kuldova og åtvarar mot ei utvikling der ein vil stole blindt på desse datasvara.

Makt

I møte med inntoget av kunstig intelligens i samfunnet, er Kuldova og kollegaane hennar i ferd med å opprette forskningssenteret Algorithmic Governance Research Network ved OsloMet.

— Det ligg så mykje makt og påvirking i algoritmene som i større og større grad er konsentrert på få hender i dei private teknologiselskapa. Data er den nye oljen vert det sagt, seier Kuldova.

Kuldova opplever sjølv at det ikkje er mykje rom for å stille kritiske spørsmål til teknologien her i landet.

— Norge er veldig digitalisert og er eit samfunn med stor grad av tillit. Alle tenker at teknologi og innovasjon er framsteg. Men i andre land, som til dømes India eller Russland, der har folk kjent på kroppen korleis det er dersom algoritmene blir misbrukte. Og det er når algoritmene blir misbrukt at vi har eit problem, seier Kuldova.

Difor vil ho ta eit oppgjer med den definisjonsmakta ho opplever at sentrale verdsaktørar har fått, i å peike på kva som er utfordringane med kunstig intelligens.

— EU og teknologi-industrien meiner utfordringane handlar om etikk og representasjon. Men ein vil aldri få eit heilt nøytralt datasett, det er umogleg. Det vil alltid vere sosiale fordommar som dei som lagar datasettet ikkje sjølve ser. Så det ligg føresetnader heile vegen.

Nylige artikler

Oxford, Yale, Stanford på topp i rangering. For «dei mest privilegerte»

Informatikkbyggets lekende prins

8 av 10 universiteter med røde tall i Frankrike: «Dette er en alvorlig advarsel»

Forlot først akademia på grunn av midlertidigheten

Raseforskere lurte til seg helsedata fra 20.000 barn

Mest leste artikler

Sykepleierstudenten har en dødelig sykdom. Mens han kan, vil han hjelpe andre

Stenger ute alle søkere fra Iran, Russland, Kina og Nord-Korea

Ønsker å bli kvitt navnetradisjonen. Vil ikke være professor emerita

Det renner inn med KI-genererte søknader. — Som en flodbølge av KI-skvip

Student ble utestengt i to år etter tre tvilsmeldinger